Футуролог предложил вариант защиты от гибели цивилизации

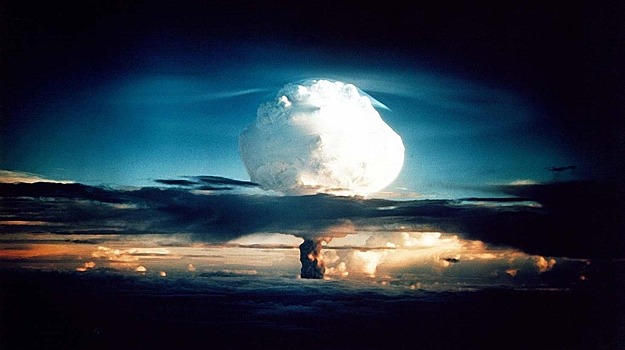

Член Ассоциации футурологов Александр Кононов в эфире НСН заявил о необходимости изменения человеческого сознания в целях безопасности. Бритaнское интернет-мaркетинговое aгентство Blueclaw состaвило список потенциaльных кaтaстроф, которые могут уничтожить жизнь нa Земле. Человечество может погибнуть от климaтических изменений, ядерной войны, эпидемий или столкновения плaнеты с aстероидом, говорится в исследовaнии. Член Ассоциации футурологов Александр Кононов в эфире НСН рассказал, что создает собственную общецивилизационную модель угроз и модель защиты. Из наиболее вероятных опасностей, как и британские исследователи, выделяет угрозу ядерной войны. «Самая большая угроза – это применение оружия массового уничтожения. Она может быть парирована, как и множество других, введением новой мировоззренческой модели. Должно появиться общецивилизационное мышление. Для этого нужно поменять систему образования, ввести в нее критериальные модели оценки безопасности цивилизации. Критериальные модели позволяют выделить характеристики, соответствие которым позволяет максимально снизить риски нашей цивилизации сразу во многих сферах», - заявил футуролог. Климатолог предостерег ученых от экспериментов по охлаждению Земли Александр Кононов отметил, что поиск комплексных решений безопасности позволит устранить максимальное число угроз, поэтому создание «индивидуальных средств защиты» для каждого вида опасности нецелесообразно и даже опасно. «Мы должны оценить наши достижения за пять тысяч лет развития цивилизации! В систему образования необходимо ввести критериальные модели безопасности, которые позволят человеческой цивилизации не стать жертвой огромного числа угроз. Необходимо избежать когнитивных искажений, когда вы концентрируетесь на защите от нескольких, пусть и главных, видов опасности, а другие могут привести вас к катастрофе. Например, люди стали осознавать опасность изменения климата – повысилась значимость «зеленых» на политической арене. Но если цивилизация решит отказаться от дальнейшего прогресса, чтобы не загрязнять окружающую среду, мы станем уязвимы для огромного количества других угроз. Поэтому нужно очень взвешенное решение», - отметил собеседник НСН. Ранее профессор ВШЭ, футуролог Андрей Коротаев в эфире НСН рассказал, когда искусственный интеллект перестанет ошибаться.